AI-Boom, Infrastrukturwelle und neue Gewinner

Der AI-Boom des Jahres 2025 hat sich von einer reinen "GPU-Story" zu einer breiten Infrastruktur-Wette entwickelt, bei der vom Hyperscaler bis zum Kabelspezialisten zahlreiche Unternehmen profitieren. Während die großen Sprachmodelle größer, multimodaler und komplexer werden, wächst der Bedarf an spezialisierter Rechenleistung, schnellen Speicherlösungen und immer leistungsfähigeren Datenverbindungen zwischen den Komponenten der Rechenzentren. Für Anleger bedeutet das: Die spannendsten Renditechancen liegen zunehmend bei jenen Firmen, die aus dem AI?Hype ein belastbares, wiederkehrendes Infrastrukturgeschäft machen – mit hoher Visibilität und klaren technologischen Differenzierungsmerkmalen.

Marktumfeld und Trendtendenzen: Santa-Rallye trifft AI-Infrastruktur

Das Marktumfeld gibt dieser Story zusätzlichen Rückenwind: Die Konjunkturdaten signalisieren eher eine Abkühlung als einen Absturz, was die Wahrscheinlichkeit für sinkende Zinsen erhöht und zyklische sowie Wachstumswerte stützt. Zugleich spielt die Saisonalität in die Karten – die vielzitierte "Santa-Rallye" zum Jahresende findet traditionell vor allem dort statt, wo ohnehin die dominierenden Jahresthemen liegen, und 2025 ist das klar der AI?Trend. In diesem Setting rücken Unternehmen in den Fokus, die nicht nur von einem kurzfristigen Bewertungs-Hype leben, sondern auf Basis harter Nachfrageindikatoren – AI?Speicher, AI?Netzwerke, AI?Chips, AI-Software – mit strukturellem Wachstum in den Jahren 2026 und darüber hinaus rechnen können.

Amazon: Vom Cloud-Pionier zum vertikal integrierten AI-Chip-Konzern

Amazon steht in dieser neuen Infrastruktur-Logik an einer strategisch besonderen Stelle: Der Konzern ist zugleich einer der größten Cloud-Anbieter, AI?Plattformbetreiber und inzwischen auch Entwickler eigener AI?Beschleuniger. Mit der Einführung des neuen Trainium3?Chips und den dazugehörigen Trn3 UltraServers macht Amazon klar, dass man sich nicht damit zufriedengibt, nur NVIDIA?Hardware zu vermarkten, sondern massiv in eigene, kosteneffiziente AI?Silicon-Stacks investiert. Anazons Trainium3 zielt dabei weniger auf ein reines "Performance-Rennen" ab als auf die ökonomische Seite des AI?Betriebs: Der Chip bietet laut AWS deutlich höhere Rechenleistung pro Watt und senkt die Kosten pro trainiertem oder inferiertem Token teils um bis zu 50 % im Vergleich zu High-End?GPU?Clustern.

Kunden wie Anthropic oder spezialisierte AI?Start-ups berichten von signifikanten Zeit- und Kostenvorteilen, was für den Cloud-Anbieter den entscheidenden Hebel bedeutet: Wer die Total Cost of Ownership großer AI?Workloads spürbar drückt, bindet Kunden langfristig an die eigene Plattform. Gleichzeitig bleibt Amazon realistisch in der Einschätzung der Marktmacht von NVIDIA: Statt einen "Entweder-oder"-Bruch zu forcieren, positioniert AWS Trainium eher als Ergänzung zu bestehenden GPU?Infrastrukturen und plant künftige Generationen, die eng mit NVIDIA?Technologien wie NVLink Fusion zusammenspielen können. Das ist strategisch klug, weil es die hohen Wechselkosten für Unternehmenskunden adressiert und einen gleitenden Übergang hin zu kostengünstigeren, AWS?eigenen Workloads ermöglicht.

Über die Chips hinaus baut Amazon das AI?Ökosystem weiter aus: Mit AI?Fabriken, Frontier Agents und der Nova?Modellfamilie entsteht ein geschlossener Stack von Infrastruktur über Basismodelle bis hin zu Agenten, die etwa Softwareentwicklung oder Security automatisieren können. Für die Investmentstory bedeutet das: AMZN wird noch stärker als bisher zu einem Basis-Asset für jede Wette auf produktive AI, das nicht allein von Konsum und klassischem E?Commerce abhängt, sondern von skalierbaren Cloud?Margen und AI?Service-Umsätzen getragen wird.

Marvell: Der unscheinbare Architekt der AI-Datenströme

Marvell Technology ist in diesem Setup so etwas wie der Architekt der Datenautobahnen zwischen AI?Chips und Speichern – ein Spezialist für Netzwerk- und Custom-Silicon-Lösungen, der bislang oft im Schatten der großen GPU?Namen stand. Die jüngsten Quartalszahlen haben jedoch gezeigt, dass sich hier eine eigenständige Wachstumsstory herausbildet: Das Unternehmen meldete ein Rekordquartal im Datacenter-Geschäft, getragen von starker Nachfrage nach AI?bezogenen Netzwerkprodukten. Der eigentliche Kurskatalysator waren aber weniger die aktuellen Zahlen als der Blick nach vorn: Marvell stellte für das Datacenter-Segment ein Wachstum von deutlich über 25 % im kommenden Geschäftsjahr in Aussicht – klar über den bisherigen Konsensschätzungen – und erwartet im darauffolgenden Jahr sogar eine weitere Beschleunigung. Besonders bemerkenswert: Diese Prognosen berücksichtigen noch nicht den vollen Effekt der angekündigten Übernahme von Celestial AI, einem jungen, auf optische Interconnect?Technologien ("Photonic Fabric") spezialisierten Unternehmen.

Mit Celestial AI kauft sich Marvell in jene Technologie ein, die als Antwort auf das größte Bottleneck moderner AI?Cluster gilt

Die Datenübertragung zwischen Rechenkernen und Speicher wird mit klassischen Kupferverbindungen zum Flaschenhals, sobald Modelle im Billionen?Parameter?Bereich trainiert werden. Optische Interconnects, die mit Licht statt Elektronen arbeiten, versprechen deutlich mehr Bandbreite bei geringerer Latenz – genau das, was Hyperscaler wie Amazon Web Services oder andere große Cloud-Anbieter benötigen. Finanziell ist der Deal ambitioniert, aber logisch: Marvell zahlt zunächst rund USD 3,25 Mrd. in Cash und Aktien, mit der Perspektive weiterer erfolgsabhängiger Zahlungen, sollte Celestial bis Ende des Jahrzehnts bestimmte Umsatzschwellen erreichen. Parallel hat Marvell sein Automotive-Ethernet-Geschäft für USD 2,5 Mrd. an Infineon verkauft und sich damit in Richtung eines fokussierten AI?Netzwerk- und Datacenter-Spezialisten verschlankt. Für Anleger ergibt sich daraus ein klarerer Equity Case: weniger Diversifizierung in zyklischen Nischen, dafür mehr Hebel auf das strukturelle Wachstumsthema AI?Infrastruktur.

Die Rolle von Amazon in Marvells Custom-Chip-Story

Eine interessante Querverbindung ist die Kooperation zwischen Marvell und Amazon beim Design spezialisierter AI?Trainingschips für AWS. Analysten hatten zwischenzeitlich befürchtet, die Nachfrage nach diesen Custom-Lösungen sei überschätzt worden, was zu hohen Erwartungshaltungen und enttäuschenden Kursverläufen führte. In der aktuellen Kommunikation signalisiert Marvell jedoch, dass die Auftragslage sich wieder aufhellt und das Custom-Silicon-Geschäft im kommenden Jahr um rund 20 % wachsen soll. Diese Projektion wird flankiert von Hinweisen auf neue Kunden – darunter ein "emerging hyperscaler" – und der Aussage des Managements, dass die früher beobachteten "Luftlöcher" in der Nachfrage nicht erneut in dieser Form auftreten sollen. Für Anleger ist das wesentlich, weil der Markt Marvell zwar als wichtigen AI?Zulieferer einordnet, die Aktie aber über Monate durch eine Serie von Enttäuschungen und überzogenen Vorschusslorbeeren unter Druck stand. Mit klareren Wachstumsleitplanken, einem bereinigten Portfolio und der Celestial?Transaktion hat sich hier das Chance-Risiko-Profil spürbar verbessert.

Micron: Speicher als Engpass und Preismacht

Micron steht an einem ganz anderen Punkt der Wertschöpfungskette – aber ebenso dicht am Puls der AI?Infrastruktur. Der Speicherhersteller liefert Hochbandbreiten?Speicher (HBM) und moderne DRAM?Lösungen, die für Training und Inferenz großer Modelle unverzichtbar sind. Nach einer zyklischen Durststrecke dreht sich die Story: Analystendaten verweisen auf ein stark positives Umsatzwachstum im Jahresvergleich und eine massiv anziehende Ergebnisperspektive, während sich die Speicherindustrie gleichzeitig in einem Angebotsregime knapper Kapazitäten bewegt.

In der jüngsten Analystenkommunikation betonte Micron?CEO Sanjay Mehrotra mehrere strukturelle Faktoren, die das Angebotswachstum in den nächsten Jahren disziplinieren dürften – von niedrigen Lagerbeständen über teure Kapazitätserweiterungen bis hin zu längeren Übergangsphasen auf neue Technologieknoten. Das Zusammenspiel aus explodierender AI?Nachfrage und gebremster Angebotsausweitung ist für einen Speicherhersteller ein ideales Setup: Es ermöglicht steigende Preise, bessere Margen und eine hohe Visibilität für Investoren. Diese Kombination aus strukturellem Rückenwind, verbesserter Preismacht und vergleichsweise moderater Bewertung macht MU für viele Investoren zu einem Kernbestandteil der AI?Infrastruktur-These bis weit in das Jahr 2026 hinein.

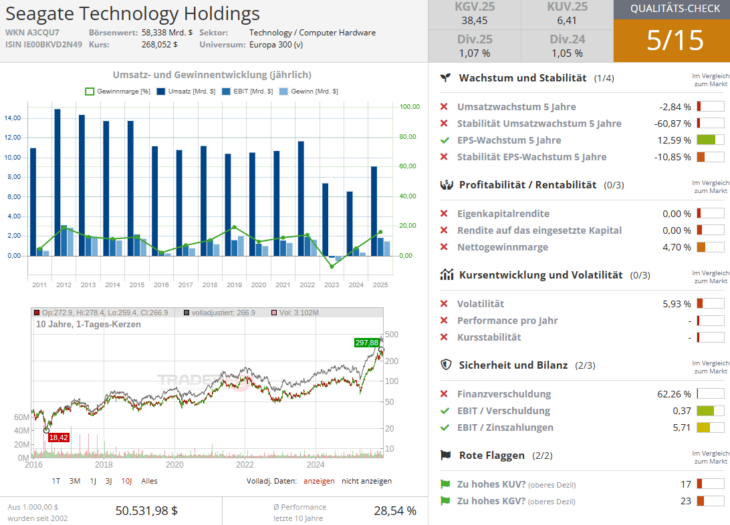

Seagate, Western Digital und Co.: Speicher-Giganten für das Zeitalter der Massendaten

Während Micron primär den flüchtigen Speicher bedient, fokussieren sich Seagate, Western Digital und Co. auf die langfristige Speicherung riesiger Datenmengen. Seagate entwickelt und produziert unter anderem Festplatten mit HAMR?Technologie (Heat-Assisted Magnetic Recording), die deutlich höhere Speicherdichten ermöglichen und damit ideal für Hyperscaler sind, die Petabytes an Trainingsdaten zu vertretbaren Kosten vorhalten müssen. Dabei hat die STX-Aktie 2025 bereits eine klassische AI?Aktienbewegung hinter sich: Nach einem starken Lauf, getrieben durch sehr gute Quartalszahlen und ein hohes Wachstum im Datacenter?Geschäft, folgte ein Rücksetzer im Zuge einer allgemeinen AI?Korrektur, auf den nun eine erneute Rallye aufsetzt.

In der jüngsten Berichterstattung hob CEO Dave Mosley hervor, dass Umsatz und Ergebnis im Septemberquartal deutlich zweistellig zulegen konnten und die Nachfrage nach hochkapazitiven Speicherlösungen robust sei. Für Investoren ist also Seagate ebenfalls ein guter Kandidat, der vom Trend zu immer größeren AI?Modellen profitiert – nicht über Hype, sondern über das sehr handfeste Problem, wo all diese Daten langfristig abgelegt werden sollen, weswegen man auch diese Aktie besonders in den Phasen charttechnischer schwächen im Blick haben sollte.

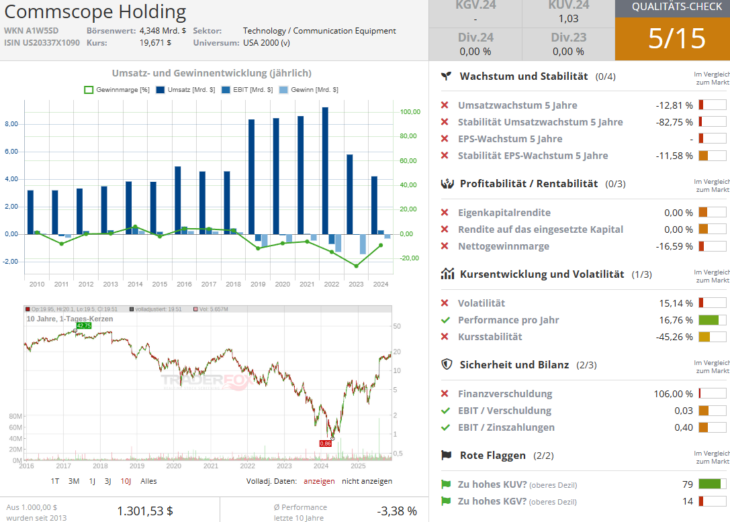

CommScope: Der unterschätzte Profiteur im Kabelschacht

Wenn AI?Rechenzentren ausgebaut werden, geht es nicht nur um Chips und Speicher, sondern vor allem um die physische Vernetzung – und hier kommt CommScope ins Spiel. Das Unternehmen liefert Glasfaser, Connectivity?Hardware und Netzwerklösungen, die nötig sind, um die deutlich dichtere und bandbreitenintensive Infrastruktur moderner AI?Cluster zu realisieren. Obwohl die Marke beim Endkunden kaum präsent ist, nimmt CommScope eine wichtige Rolle im "Backstage"-Bereich der digitalen Infrastruktur ein, vom Datacenter bis ins Unternehmensnetz.

Die Investmentstory bei COMM wird derzeit stark über die Bewertung definiert: In Screenings fällt die Aktie v.a. durch ein günstigeres KGV (rund 10,92 für 2026) auf, während die erwartete EBITDA?Dynamik zumindest leicht über dem Sektor liegt. Zusätzlichen Rückenwind brachte der angekündigte Verkauf des Community?Cable?Segments (CCS) für 10,5 Mrd. USD an Amphenol (APH), mit dem CommScope seine Bilanz entschlackt und sich stärker auf Breitband- und Enterprise?WiFi?Lösungen fokussiert. Der Markt honorierte diesen Schritt mit einer spürbaren Kurserholung – ein Signal, dass Investoren den strategischen Fokus und die Entschuldung positiv bewerten. In der AI?Infrastruktur-Story fungiert CommScope damit als Hebel auf den physischen Ausbau: Je mehr AI?Kapazität Hyperscaler und Unternehmen installieren, desto höher der Bedarf an Glasfaser, Verteiltechnik und leistungsfähiger Verkabelung. Für Anleger, die nicht nur auf die prominenten Chip-Namen setzen möchten, eröffnet COMM einen diversifizierenden Zugang zu dem Thema – mit einem Profil, das stärker von Infrastruktur?Capex als von Software- oder Modellzyklen abhängt.

Sektorblick: AI?Infrastruktur als mehrstufige Wertschöpfungskette

Zusammengenommen zeichnen diese Stories ein Bild einer mehrstufigen Wertschöpfungskette, in der verschiedene Sektoren ineinandergreifen. Auf oberster Ebene stehen die Hyperscaler wie Amazon, die nicht nur Cloud?Kapazität verkaufen, sondern zunehmend eigene AI?Chips, Modelle und Agenten bieten. Darunter operieren Spezialisten wie Marvell, die für die Vernetzung der AI?Cluster sorgen, während Speicherhersteller wie Micron und Seagate die nötigen Kapazitäten für Arbeitsspeicher und Datenspeicher liefern und Netzwerkausrüster wie CommScope die physische Infrastruktur bereitstellen.

Für Anleger entsteht daraus eine Art "AI?Infrastrukturkorb", der sich bewusst von reinen GPU?Wetten absetzt und breiter aufgestellt ist. Der gemeinsame Nenner dieser Titel: Sie profitieren nicht nur von einzelnen Modellzyklen, sondern von einem säkularen Trend, in dem Unternehmen weltweit ihre IT?Landschaften in AI?fähige Infrastrukturen transformieren – eine Entwicklung, die über Jahre laufen dürfte und über kurzfristige Zins- oder Konjunkturdaten hinausreicht.

Der Blick nach vorn ist dennoch nicht frei von Risiken: Die starke Abhängigkeit vom Investitionszyklus der großen Hyperscaler, potenzielle Überkapazitäten nach Investitionswellen und ein verschärfter geopolitischer Wettbewerb im Technologiesektor können immer wieder zu Volatilität führen. Zugleich verändern politische Rahmenbedingungen – etwa unter dem US?Präsidenten Donald Trump – die Spielregeln bei Handel, Tech?Regulierung und Subventionspolitik, was sowohl Chancen (Förderprogramme, Steuererleichterungen) als auch Risiken (Exportkontrollen, Handelskonflikte) birgt.

Die zentrale Investmentthese bleibt jedoch vollkommen intakt: Die AI?Revolution hat sich von einer Software- und Modellgeschichte hin zu einem groß angelegten Infrastrukturprojekt entwickelt, das Milliardeninvestitionen in Rechenzentren, Netzwerke und Speicher erfordert. In diesem Umfeld erscheinen die in diesen Trendupdate thematisierten Aktien wie AMZN, MRVL, MU, STX und COMM besonders interessant, weil sie an entscheidenden Knotenpunkten dieser neuen Infrastruktur sitzen und von jedem neu aufgebauten AI?Cluster direkt oder indirekt profitieren.

Viel Erfolg und bleiben Sie Profitabel!

Verantwortlicher Redakteur Kulikov Leonid: keine Eigenpositionen.